버젼 PC MacLAN8

◆ 이기종간의 파일공유를 위한 기초지식

컴퓨터 간의 네트웍 규약을 프로토콜이라고 한다.

네트웍 구성시 사용을 하는 프로토콜에는 여러 가지가 있으나

파일공유시 매킨토시에서 기본적으로 사용하는 프로토콜은 AppleTalk이고

IBM 계열의 PC(이하 PC라 명칭)에서는 노벨네트웍, 즉 NetBEUI를 기본 프로토콜로 사용을 한다.

그리고 인터넷을 이용하는 경우에는 TCP/IP라는 프로토콜을 사용하게 된다.

여기에서 우리는 기종간의 프로토콜 사용에 차이가 있음을 보게 되는데

이 부분을 곰곰히 생각해보면 이기종간의 네트웍을 위해 필요한 조치가 무엇인지를 알 수 있다.

PC에서 AppleTalk을 사용할 수 있게 설정을 하거나 아니면 그와는 반대로

맥에서 NetBEUI를 사용할 수가 있다면 이 두 기종간의 네트웍이 가능하다.

따라서 여기에서 소개하는 두 프로그램들이 그러한 역할을 하게 되는데

DAVE의 경우에는 TCP/IP를 이용하여 NetBIOS를 지원하는 방식으로

AppleTalk을 직접 지원하는 PC MACLAN과는 이용방식에 차이가 있다.

DAVE는 매킨토시에 설치를 하고 PC MACLAN은 PC에 설치를 하게 된다.

둘 중 어느 방식을 취할 것인지는 네트웍 구성 상의 환경에 따라 판단을 하게 되는데

PC가 다수 있고 매킨토시가 한 대 있는 사무실을 예로 든다면 한 대 뿐인 매킨토시에

DAVE를 설치하여 PC의 네트웍에 참여를 시키는 것이 가장 간단한 방법일 것이다.

만약 이와는 반대로 구성을 하는 경우라면 다수의 PC에 각각 PC MACLAN을 설치해야 하므로

설치상의 시간적인 소요나 비용에 있어서 바람직하지 못한 면이 많다.

※ 준비할 사항들

우선은 네트웍의 기기적인 구성을 한다.

컴퓨터 두 대를 1:1로 연결을 하는 경우라면 크로스케이블로 직접 연결하는것 만으로도

준비가 완료될 수도 있다. 하지만 두 대 이상인 경우에는 반드시 허브를 경유하여

네트웍을 구성해야 하며 단 두 대일 경우에도 허브를 사용하여 구성을 할 수가 있다.

허브를 사용하는 경우에는 다이렉트케이블을 사용하게 된다.

그 다음이 소프트웨어의 준비다.

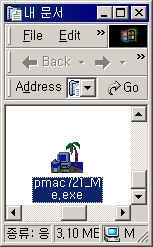

우선 프로그램의 해당 제작회사의 홈페이지에 접속을 하여 Demo 버젼을 다운로드 한다.

PC MACLAN : Miramar Systems (http://www.miramarsys.com)

DAVE : Thursby Software (http://www.thursby.com)

단, PC MACLAN은 Windows 95/98용, Windows ME,

그리고 Windows 2000/NT/XP 버젼이 따로 있으므로 선별하여 다운로드 한다.

그리고 DAVE의 경우에는 다운로드 양식을 작성해야 하며 작성 항목에 있는

이메일 주소를 정확하게 기재를 하여야 Evaluation Key에 관한 회신을 받게 된다.

이 Evalution Key를 입력해야 사용이 가능하다.

◆ PC MACLAN의 설치 및 설정

만약 바이러스 감시 프로그램 등이 기동이 되어 있는 경우라면

설치 전에 해당 프로그램을 종료를 시킨 후에 설치를 하는 것이 좋다.

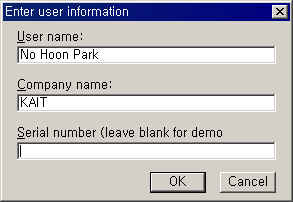

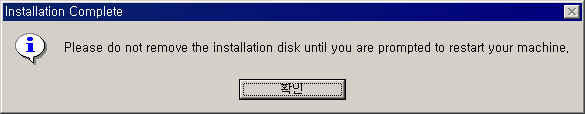

설치 프로그램을 실행하면 압축이 풀리게 되며 압축이 풀림과 동시에 설치가 진행이 된다.

설치 도중에 시리얼번호를 물어오게 되는데 Demo의 경우 해당 항목을 공란으로 진행을 한다.

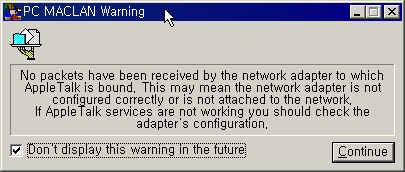

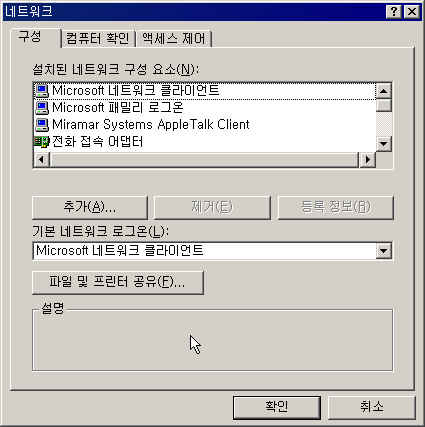

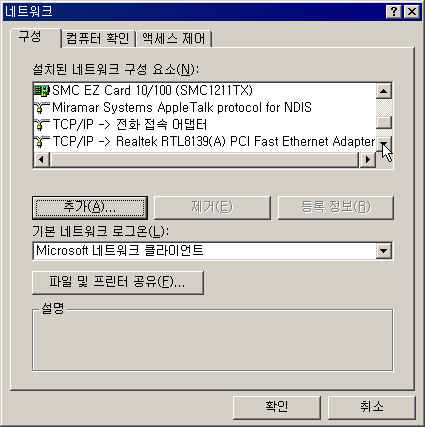

재시동이 완료되면 시작-->설정-->제어판에서 네트워크를 실행하여

아래 화면에서 처럼 "설치된 네트워크 구성 요소" 중에

AppleTalk Client와 Protocol이 설치가 되어 있음을 확인할 수 있다.

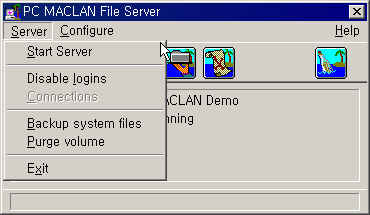

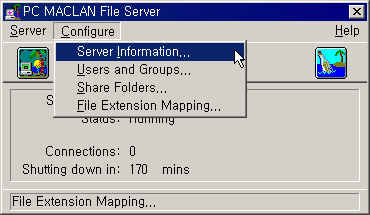

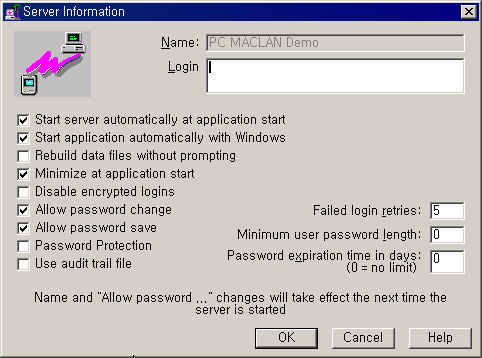

Server 기능이 기동이 된다고 해서 바로 파일공유가 이루어지는 것은 아니며 다른 경우에서와

마찬가지로 서버의 기본환경에 대한 설정을 맞추고 파일공유를 위해 접속하는 사용자에 대해

권한 설정을 해주어야 하며 공유할 폴더나 하드디스크 등에 대한 지정을 하여야 한다.

그리고 PC MACLAN이 실행이 되고 난 이후에 달리 설정을 할 부분이 없으므로

이제 서버의 기본환경에 대한 설정은 완료가 되었다.

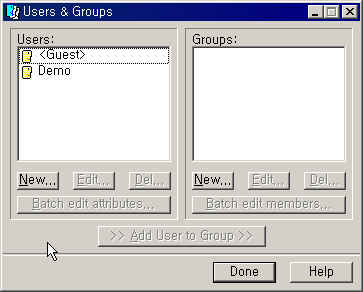

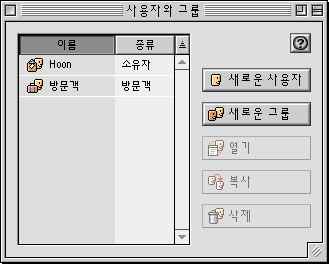

여기에서 한 가지 보완설명을 한다면 추후에 필요에 따라 그룹을 생성한다든가

Configure 메뉴에서 Share Folders를 실행하여 공유할 폴더를 지정을 하게 된다.

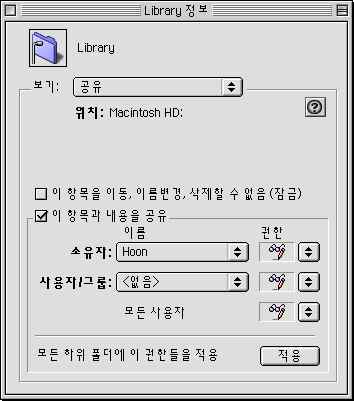

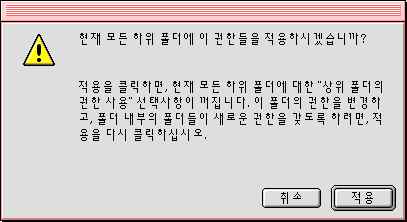

공유할 폴더를 선택한 후에 Share 버튼을 눌러 권한을 지정하게 된다.

앞에서 설명한 바와 같이 여러 개의 공유 폴더를 생성하여 각 공유 폴더 별로 접속할 수 있는

사용자들의 권한을 조정할 수 있다.

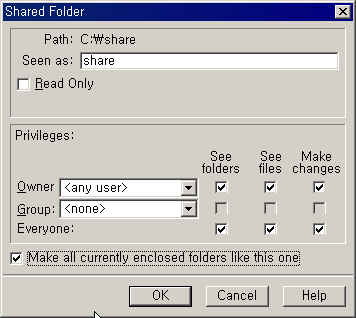

아래의 화면이 해당 공유 폴더로 접속하는 사용자에 대한 권한을 설정하는 부분이다.

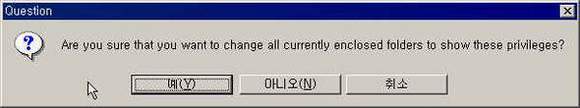

단, 이 번 예제에서는 등록사용자가 아닌 Guest로서도 접속을 할 수 있도록

Everyone에 읽기/쓰기/파일관리의 모든 권한을 지정하게 된다

이로써 PC에서의 설정은 완료가 되었으며 이제부터 매킨토시의 설정을 진행하도록 한다.

◆ 매킨토시에서의 설정

이미 설명을 한 바와 같이 PC MACLAN은 AppleTalk을 Protocol로 사용을 함으로로써

매킨토시와의 네트웍이 가능해지는 방식이다.

따라서 매킨토시의 방식을 따르게 되므로 매킨토시에서의 설정은

일반적인 매킨토시간의 네트웍 설정과 동일하다.

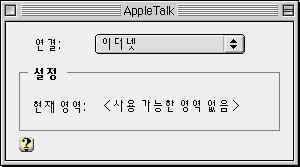

우선 조절판의 AppleTalk에서 이더넷으로 맞추고 윈도우를 닫으면서 저장을 합니다

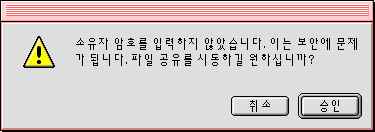

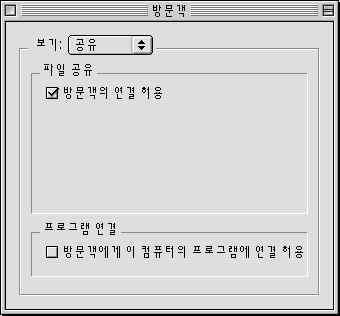

참고로 등록사용자가 아닌 방문객의로서의 접근도 가능하도록 설정을 할 것이며

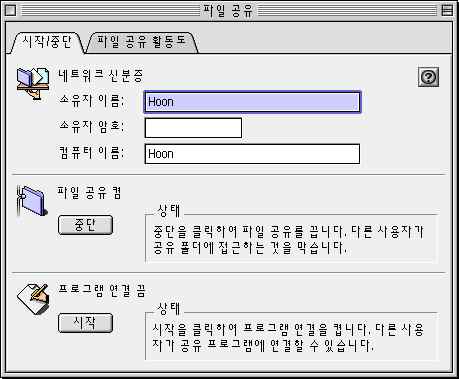

필자는 한글 시스템 8.6을 사용하였기 때문에 파일 공유 윈도우에

방문객의 접속에 대한 권한을 설정하기 위하여 사용자와 그룹 상에 있는 방문객을

이로써 이 번 예제에서는 PC에서 매킨토시로 접근을 하는 경우이든

공유를 지정할 폴더를 마우스로 선택을 하고 데스크탑 상의 파일 메뉴에서

이제 매킨토시에서 먼저 파일 공유가 진행이 되는지의 여부를 확인하도록 하겠다.

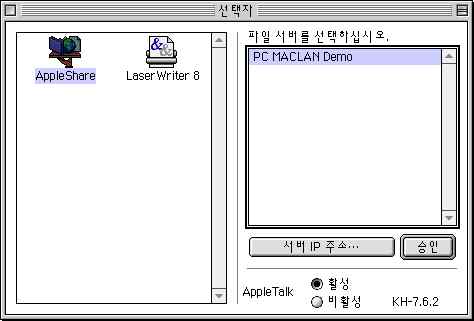

선택자에서 AppleShare를 선택하면 파일서버인 PCMACLAN DEMO가 나타난다.

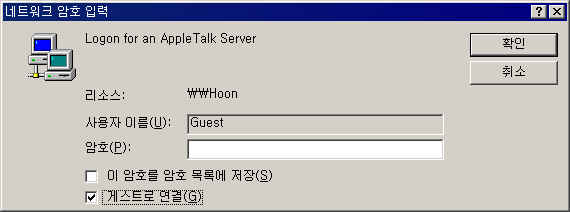

이를 더블 클릭을 하여 접속을 시도하게 됩니다. 방문객으로서도 접근을 할 수 있도록

설정을 하였으나 DEMO 버젼인 관계로 일부 제한이 있어 접근이 허용이 되지를 않는다.

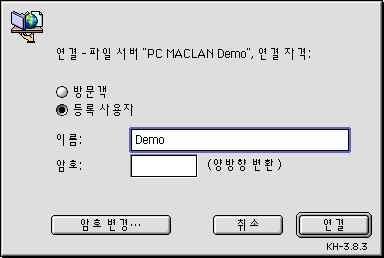

따라서 등록 사용자인 Demo를 이름 항목에 기입하여 연결(Demo 버젼 사용자에 한함) 한 후에

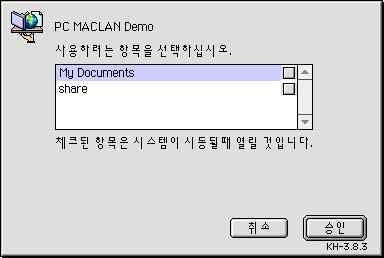

두 개의 공유 폴더 중에서 My Document에 연결한다.

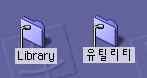

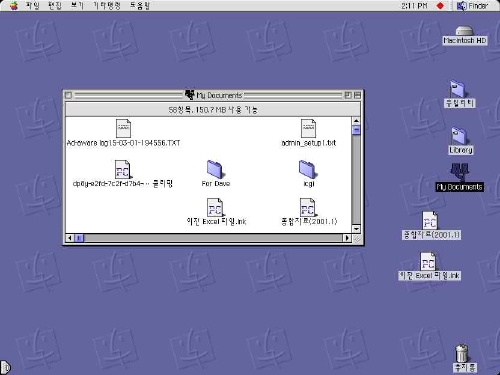

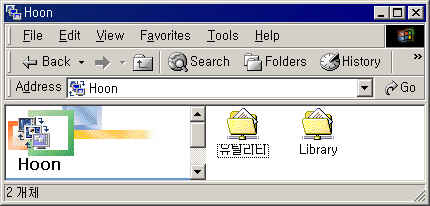

매킨토시의 데스크탑 상에아래와 같이 PC의 공유 폴더 중의 하나인

My Documents가 마운트가 된다.

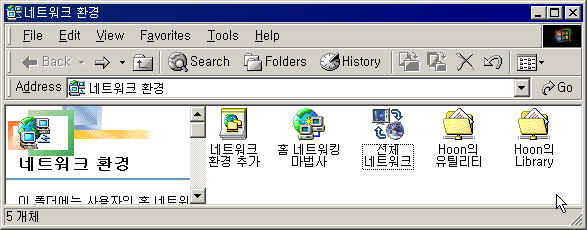

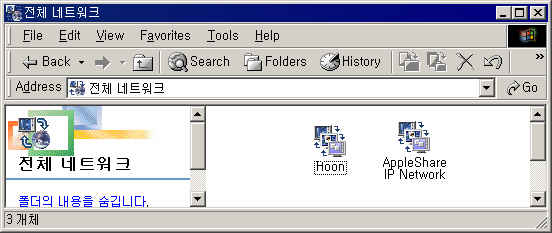

네트워크 환경 윈도우에 매킨토시의 공유 폴더인 Hoon의 유틸리티와

원본 : 피앙세 님

'OS > WINDOWS' 카테고리의 다른 글

| windows server 네트워크로드 밸런싱 (0) | 2008.11.06 |

|---|---|

| Firefox(불여우) 사용자를 위한 필수 Add-on 프로그램들 (0) | 2008.03.09 |

| [펌] 윈도우 다시 설치할 때 백업하고 복원해야 할 것 (0) | 2005.04.01 |

| [펌] 아웃룩백업 및 복구하기 (0) | 2005.03.31 |

| [MS-Office]Outlook과 Outlook Express 메일 및 주소록 백업 (0) | 2005.03.23 |